Técnica de RAG para crear tu propio modelo de inteligencia artificial en la empresa

La técnica de RAG para crear un modelo de inteligencia artificial corporativo combina la recuperación de información y la generación de texto para mejorar la precisión de los modelos de lenguaje. Al integrar datos externos y contextualmente relevantes, RAG proporciona respuestas más informadas y precisas, superando las limitaciones de los modelos tradicionales. Es crucial que las empresas creen su propio modelo de inteligencia artificial con información privada para maximizar la relevancia y precisión de las respuestas.

Los Large Language Models (LLMs) son modelos de inteligencia artificial entrenados mediante algoritmos de Deep Learning sobre grandes volúmenes de información generada por humanos. Este proceso permite a los LLMs aprender cómo utilizamos el lenguaje hablado y escrito, lo que les capacita para ofrecer respuestas coherentes y similares a las humanas a nuestras preguntas. No obstante, cuando se trata de obtener respuestas precisas en contextos específicos, los LLMs pueden fallar, generando respuestas inexactas o inventadas, un fenómeno conocido como «alucinación».

Aunque los LLMs son herramientas poderosas para generar texto coherente y humano, es crucial ser conscientes de sus limitaciones y considerar soluciones complementarias, como el uso de Retrieval-Augmented Generation (RAG), para mejorar la precisión y relevancia de las respuestas generadas.

Las técnicas RAG mejoran la calidad de las respuestas en contextos específicos. Estas técnicas son especialmente útiles en disciplinas concretas como el ámbito legal, la medicina, o en repositorios de conocimiento privados, como las bases de datos de empresas.

¿Qué es la técnica de RAG?

RAG es una técnica que combina la recuperación de información y la generación de texto para mejorar la precisión y fiabilidad de los modelos generativos de IA. Utilizando datos externos, RAG enriquece el conocimiento del modelo, proporcionando respuestas más informadas y contextualmente relevantes.

A continuación, se desglosan las tres fases clave de RAG: Recuperación de Información, Augmentación y Generación.

- Recuperación de Información (retrieval): En esta fase, el sistema de IA accede a una base de datos o una colección de documentos externos para recuperar información relevante que complemente la generación de texto al ejecutar un prompt utilizando un modelo de inteligencia artificial.

- Augmentación (augmentation): La información recuperada se utiliza para enriquecer el conocimiento del modelo de inteligencia artificial, proporcionando un contexto adicional que el modelo puede emplear para producir respuestas más detalladas y precisas. Este paso es crucial para mejorar la capacidad del modelo de generar respuestas basadas en datos actuales y relevantes, en lugar de depender únicamente de su conocimiento previo. La augmentación asegura que el modelo tenga acceso a la información más actualizada y pertinente.

- Generación (generation): Finalmente, el modelo generativo utiliza tanto su conocimiento previo como la información recuperada para generar la respuesta final. Este proceso implica crear texto coherente, preciso y contextualizado que responda adecuadamente a la consulta original. La generación se realiza utilizando modelos de lenguaje preentrenados, como GPT-4 o Gemini, que se ajustan finamente con la información recuperada para producir resultados de alta calidad y relevancia.

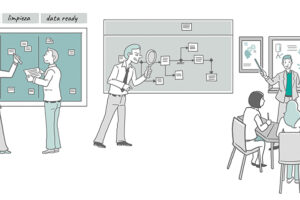

Proceso en la técnica de RAG

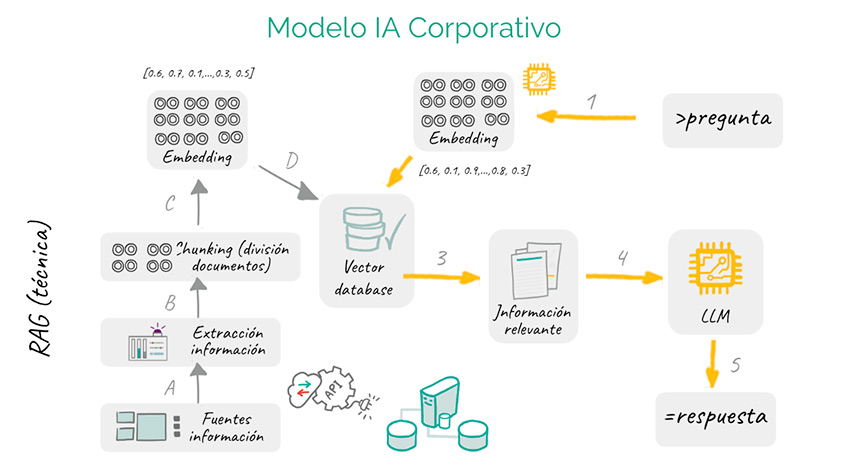

El diagrama ilustra cómo funciona la técnica RAG (Recuperación-Augmentación-Generación) en combinación con un modelo de lenguaje (LLM) para proporcionar respuestas más precisas y contextualmente relevantes.

A continuación, se describe el proceso basado en la imagen adjunta.

- Pregunta: El proceso comienza cuando se hace una pregunta en el chat.

- Embedding de la pregunta: La pregunta se convierte en un vector de embeddings, una representación numérica de alta dimensión que captura el significado semántico de la pregunta.

- Recuperación de información relevante: Este embedding se utiliza para buscar información relevante en una base de datos vectorial (Vector database). Esta base de datos contiene documentos y datos previamente convertidos en embeddings.

- Chunking y extracción de información: Los documentos en la base de datos se dividen en partes más pequeñas (chunking) y se extrae la información relevante de diversas fuentes. Los documentos o partes de documentos extraídos también se representan como embeddings.

- Selección de información: Se selecciona la información más relevante basada en la similitud de los embeddings con la pregunta original.

- Alimentación del modelo LLM: La información relevante seleccionada se envía al modelo de lenguaje (LLM) junto con la pregunta original.

- Generación de la respuesta: El LLM utiliza la información proporcionada para generar una respuesta que sea precisa y contextual.

- Respuesta final: La respuesta generada se presenta al usuario.

En resumen, el proceso RAG mejora la capacidad del modelo de lenguaje para proporcionar respuestas más precisas y relevantes al enriquecer su conocimiento (modelo preentrenado, como por ejemplo GPT-4o) con información externa específica y actualizada utilizando la técnica de RAG.

¿Por qué usar la técnica de RAG?

RAG ofrece varias ventajas sobre los métodos tradicionales de los LLM (Chatgpt, Gemini o Claude), especialmente cuando se trata de información factual o respuestas basadas en datos. A continuación, se presentan algunas razones clave por las cuales RAG es un excelente recurso:

Acceso a información actualizada. Los modelos de lenguaje tradicionales (LLMs) suelen estar limitados a la información y datos con los que fueron entrenados. Esto puede resultar en respuestas desactualizadas o inexactas. RAG resuelve este problema proporcionando a los LLM acceso a fuentes de información externas, asegurando respuestas precisas y actualizadas.

Base factual. Aunque los LLM son herramientas potentes para generar texto creativo y atractivo, a veces pueden fallar en la precisión factual debido a las posibles inexactitudes o sesgos presentes en los datos de entrenamiento. RAG aborda este problema ofreciendo acceso a una base de conocimiento curada, garantizando que el texto generado esté basado en información verificable y actualizada.

Relevancia contextual. El mecanismo de recuperación en RAG asegura que la información obtenida sea relevante para la consulta que el usuario realiza. Al proporcionar información contextualmente relevante, RAG ayuda al modelo a generar respuestas más coherentes y alineadas con el contexto dado, reduciendo así la generación de respuestas irrelevantes o fuera de tema.

Uso de bases de datos vectoriales. RAG utiliza bases de datos vectoriales para recuperar documentos relevantes de manera eficiente. Estas bases almacenan documentos como vectores, que son subconjuntos de datos organizados por similitud semántica, en un espacio de alta dimensión. Este enfoque permite una recuperación rápida y precisa basada en el contenido, asegurando que la información relevante se obtenga de forma eficiente.

Mejora la precisión de las respuestas. RAG complementa a los LLM proporcionando información contextualmente relevante que el modelo puede utilizar para generar respuestas más coherentes, informativas y precisas, incluso en contextos multimodales.

En conclusión, RAG supera las limitaciones de los modelos de lenguaje tradicionales al mejorar la precisión y relevancia de las respuestas generadas, haciendo que esta técnica sea especialmente útil en aplicaciones que requieren información actualizada y precisa.

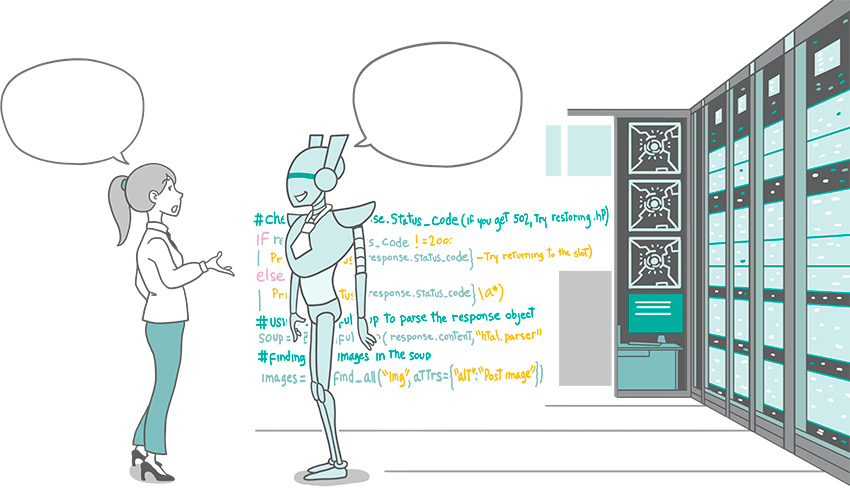

Modelo de Inteligencia Artificial Corporativo

Imaginemos una empresa que desea innovar y mejorar sus estrategias utilizando un modelo de inteligencia artificial (IA) personalizado. Esta empresa decide subir toda su documentación promocional, su modelo de negocio, el catálogo de productos, así como información detallada sobre sus procesos, departamentos y funciones. Con toda esta información interna disponible y el uso de la inteligencia artificial, la empresa puede diseñar estrategias más efectivas y específicas.

Por ejemplo, si aplicamos los 10 tipos de innovación de Doblin y subimos toda la teoría del método a nuestro modelo de IA, junto con la documentación interna de la empresa, se puede lograr una innovación sin precedentes. Aquí es donde la técnica RAG (Recuperación-Augmentación-Generación) entra en juego para potenciar las capacidades del modelo de IA.

Proceso de integración y beneficios:

- Subida de documentación interna: La empresa carga toda su información interna, desde documentación promocional hasta catálogos de productos y detalles de procesos internos, en el sistema de IA.

- Incorporación de metodologías de innovación: Se añade la teoría de los 10 tipos de innovación de Doblin al modelo de IA. Esta metodología ofrece un marco estructurado para identificar y aplicar distintas formas de innovación en la empresa.

- Recuperación de información relevante: Utilizando RAG, el modelo de IA puede acceder a la información específica de la empresa y la teoría de innovación para proporcionar respuestas precisas y contextualmente relevantes.

- Generación de estrategias innovadoras: El modelo de IA, enriquecido con datos internos y teoría de innovación, puede generar estrategias detalladas y personalizadas. Por ejemplo, puede identificar oportunidades de mejora en el modelo de negocio, sugerir nuevas formas de promoción basadas en datos del catálogo de productos, o proponer optimizaciones en los procesos internos.

Ventajas de este enfoque:

- Precisión y relevancia: Las respuestas y estrategias generadas estarán alineadas con la realidad interna de la empresa, ofreciendo soluciones prácticas y efectivas.

- Seguridad de la información: Al mantener la información dentro de un sistema de IA propio, se garantiza la privacidad y confidencialidad de los datos.

- Personalización y adaptabilidad: El modelo de IA se ajusta a las necesidades específicas de la empresa, permitiendo una innovación más dirigida y efectiva.

- Mejora continua: Con la capacidad de actualizar continuamente el modelo con nueva información y casos específicos, la empresa puede mantener una ventaja competitiva constante.

Proveedores

Proveedores y servicios code-less para crear modelos de inteligencia artificial personalizados

En la actualidad, existen varios proveedores que ofrecen la posibilidad de crear modelos de inteligencia artificial personalizados sin la necesidad de programar (code-less). Estos servicios permiten a las empresas aprovechar la IA para mejorar sus estrategias y operaciones, utilizando plataformas intuitivas y accesibles.

A continuación, se presenta una descripción general de estos servicios y un análisis específico de algunas de las principales opciones disponibles en el mercado: GPTs en ChatGPT de OpenAI, Projects en Claude con Sonnet 3.5 de Amazon, y Vertex AI Agent Builder de Google.

Los servicios code-less para la creación de modelos de inteligencia artificial corporativos se caracterizan por ofrecer interfaces amigables que permiten a los usuarios configurar y entrenar modelos de IA sin necesidad de conocimientos en programación. Estos servicios suelen incluir herramientas visuales y flujos de trabajo simplificados para cargar datos, definir objetivos y ajustar parámetros, facilitando el desarrollo y despliegue de soluciones de IA personalizados con información corporativa.

GPTs en ChatGPT

Descripción: ChatGPT de OpenAI ofrece una plataforma para crear y personalizar tu propio modelo de inteligencia artificial utilizando GPT (Generative Pre-trained Transformer). Esta solución es ideal para empresas que buscan integrar el modelo de inteligencia artificial LLM con su información corporativa.

Características:

- Ventana de contexto: La ventana de contexto es la cantidad de información que un modelo de inteligencia artificial puede procesar y recordar en una sola interacción. Especifica el número máximo de tokens (o palabras) que el modelo puede manejar al mismo tiempo. ChatGPT-4o dispone de una ventana de contexto de 128,000 tokens (aproximadamente 96,000 palabras) permitiendo que el modelo considere una gran cantidad de información de manera simultánea cuando ejecuta una petición de usuario.

- Capacidad de carga de documentos: La capacidad máxima es de 10GB, distribuida en hasta 20 archivos de 512MB cada uno. Sin embargo, es importante tener en cuenta que los archivos de más de 100MB no obtienen el mismo rendimiento, lo que puede afectar la eficiencia del procesamiento de información.

- Técnica RAG: Combina la técnica de Recuperación-Augmentación-Generación (RAG) para integrar información relevante de la empresa y fuentes de información externas para mejorar la precisión de las respuestas.

- Integración: Fácil integración con aplicaciones y sistemas empresariales a través de la conexión por OpenAPI (function calling).

Ventajas:

- Gran capacidad de personalización y flexibilidad.

- Amplia ventana de contexto, aunque no la mayor.

- Soporte robusto de OpenAI.

Projects de Claude con Sonnet 3.5

Descripción: Projects de Claude, utilizando Sonnet 3.5 (modelo IA de Antrohpic), es una plataforma diseñada para facilitar la creación de proyectos de IA sin necesidad de programación. Esta herramienta está orientada a usuarios empresariales que desean desarrollar soluciones de IA de manera rápida y eficiente.

Características:

- Ventana de contexto: Hasta 200,000 tokens, permitiendo cargar y procesar una mayor cantidad de información de contexto en una sola interacción.

- Capacidad de carga de documentos: Limitada a unas 400 páginas, lo que puede restringir la cantidad de información que se explotar en la base de conocimiento.

- Acceso a los Projects: Puedes acceder a cada uno de los proyectos directamente desde la ventana de chat. La posibilidad de crear múltiples proyectos permite establecer un contexto muy amplio al ejecutar prompts (instrucciones en el chat), facilitando así la gestión y organización de la información.

- Capacidades de diálogo: Soporte para la creación de flujos de conversación complejos y contextualmente relevantes con la utilización de los Projects.

Ventajas:

- Mayor ventana de contexto, ideal para proyectos que requieren manejar grandes volúmenes de información en una sola interacción.

- Alta usabilidad y reducción de tiempo de desarrollo.

- Gran precisión trabajando con un documento específico.

Desventajas:

- Capacidad de carga de documentos más limitada en comparación con GPTs.

- Falta de información específica sobre la capacidad de aprendizaje comparada con otros modelos.

- No está claro la útilización de la técnica de RAG ya que cargan toda la información almacenada en contexto.

Vertex AI Agent Builder

Descripción: Vertex AI Agent Builder es parte de la suite de Vertex AI de Google Cloud, que permite a las empresas construir y desplegar agentes de IA personalizados sin programación. Este servicio es adecuado para crear asistentes virtuales, chatbots y otras aplicaciones interactivas basadas en IA.

Características:

- Interfaz de usuario: Herramientas visuales para diseñar y entrenar agentes de IA.

- Escalabilidad: Capacidad de escalar fácilmente según las necesidades del negocio.

- Integración profunda: Integración con Google Cloud y otros servicios de Google.

- Almacenamiento de datos: Con Agent Builder, puedes crear diferentes almacenes de datos como contenido de sitios web, Google Drive, CloudSQL, almacenamiento en la nube y bases de datos vectoriales. Además, puedes acceder a sistemas externos mediante APIs, ofreciendo una versatilidad sin igual para gestionar y utilizar tus datos de manera eficiente.

Ventajas:

- Control avanzado sobre la configuración de la técnica de Retrieval-Augmented Generation (RAG), permitiéndote crear tu propio modelo de inteligencia artificial adaptado a tus necesidades específicas.

- Integración profunda con el ecosistema de Google Cloud, facilitando el acceso a otros servicios y herramientas.

- Escalabilidad y robustez para manejar aplicaciones complejas.

Desventajas:

- Es mucho más complejo de configurar que cualquiera de los anteriores.

- Posible dependencia del ecosistema de Google Cloud para maximizar sus beneficios.

Posts relacionados

- Cómo entrenar los GPT de OpenAI

- Cultura IA como motor de cambio en empresas

- Cómo migrar o fusionar de ChatGPT Personal a ChatGPT Team

- Mapa conceptual IA para crear tu estrategia en Inteligencia Artificial

- Gemini Advanced como evolución a Bard

- GPT Store de OpenAI impulsa una nueva era de modelos GPT.

- ChatGPT Team para garantizar la seguridad y privacidad en la pyme.

- SGE de Google revoluciona la búsqueda con IA Generativa

- MyGPT democratiza la creación de IA

- Riesgos de ChatGPT y el desafío para las pymes.

- Ingeniería de prompts: diseño efectivo para resultados óptimos